“AI闭环”假期刷屏!一文读懂北美数据中心供应链

人工智能竞赛的本质,是一场关于物理基础设施的竞赛。屏幕上每一次流畅的AI交互背后,都是数据中心内数以万计的服务器在高速运转,而支撑这一切的,是一个正在以惊人速度膨胀的万亿级实体产业——数据中心。

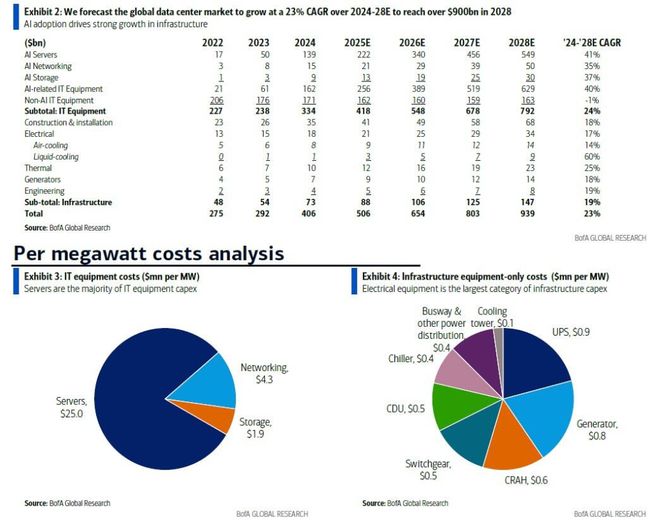

据美国银行(BofA)测算,全球数据中心资本支出在2024年已突破4000亿美元,2025年将达到5060亿美元,其中IT设备支出4180亿,基础设施支出880亿。在AI需求的驱动下,该市场预计在2024至2028年间,将以高达23%的惊人年复合增长率(CAGR)扩张,最终在2028年形成一个超过9000亿美元的庞大市场。

那么,在这场前所未有的建设热潮中,真正的价值链分布在何处?谁将成为最大的受益者?

本文将深入剖析这场由AI引爆的数据中心市场全景,揭示技术变革的核心逻辑,并系统性拆解其复杂的供应链,为您完整呈现一幅北美数据中心供应链的全景图,并找出在这场淘金热中真正的“卖铲人”。

一、5000亿美元市场全景

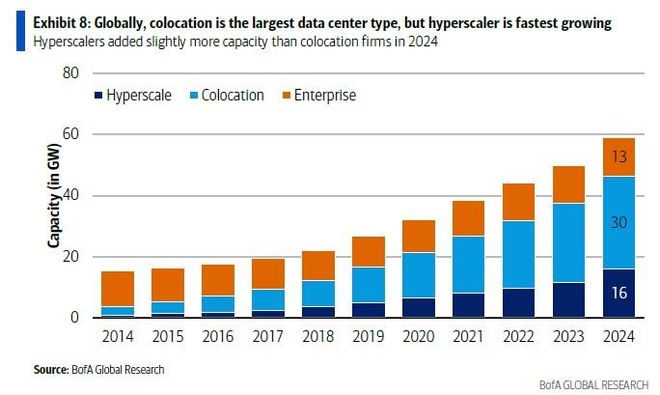

数据中心市场的增长,已不再由传统企业自建自用驱动。自2017年以来,云服务商和托管公司的总容量首次超越企业自建数据中心后,几乎所有的新增容量都来自于两类玩家:以亚马逊AWS、微软Azure为代表的“超大规模”(Hyperscale)云服务商,以及为它们或其它客户提供租赁服务的“托管”(Colocation)公司。

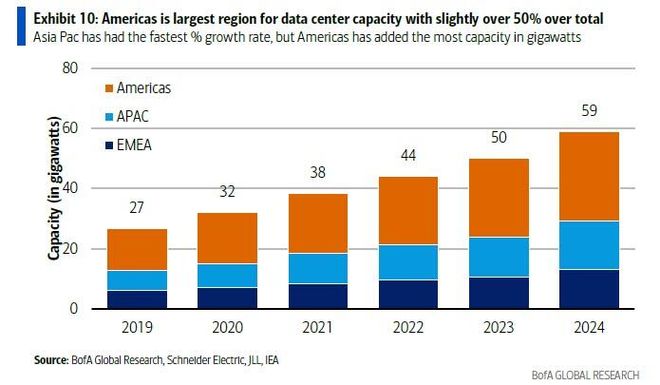

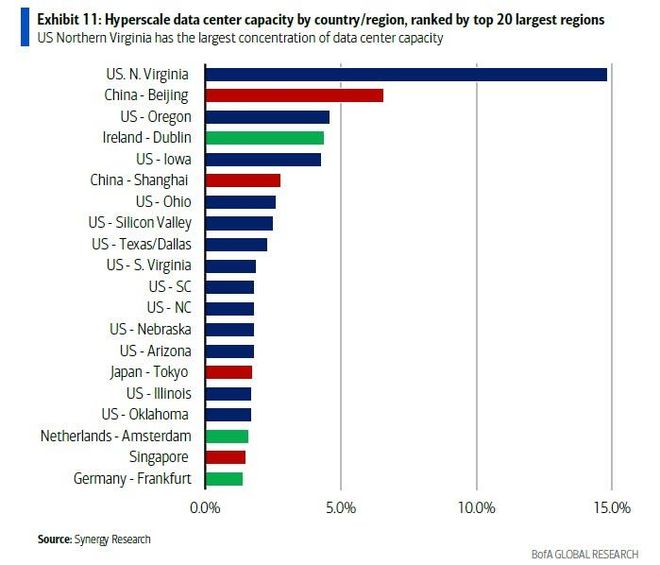

从全球产能分布来看,美洲地区占据了全球过半的电力容量,其中,美国东海岸的北弗吉尼亚州,以其近15%的全球超大规模数据中心容量,成为无可争议的全球最大单一聚集地。紧随其后的是咱们中国的北京,约占7%。

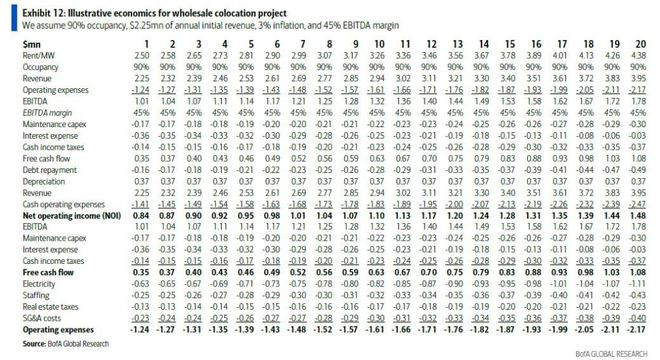

驱动资本持续涌入的,是数据中心作为一种高价值基础设施资产清晰且可观的回报模型。以一个典型的批发托管(Wholesale Colocation)新建项目为例,其单位投资经济学如下:

正是这种高确定性的商业模式,构成了整个数据中心产业扩张的金融基石。

二、技术奇点来临:从芯片到机架的“密度革命”

数据中心内部所有基础设施变革的起点,都源自AI芯片。其核心演进逻辑可以被精确地概括为一场“密度革命”。

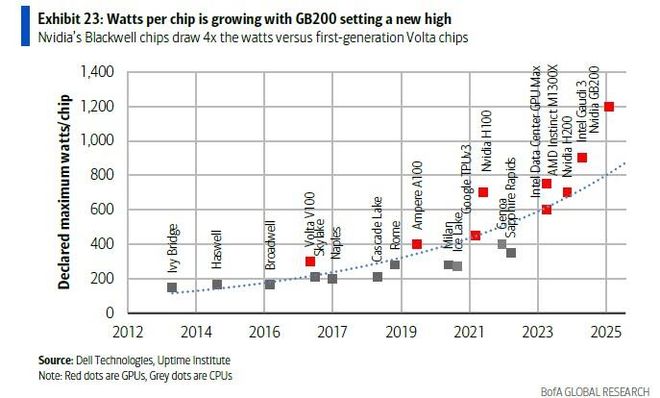

革命的根源,是单颗芯片功耗的指数级飙升。从英伟达的第一代Volta架构到如今的Blackwell架构,单颗GPU的功耗在短短数年间增长了4倍。这背后的物理定律简单而残酷:在芯片上集成更多晶体管、并以更高时钟频率运行,必然导致功耗的线性增长。

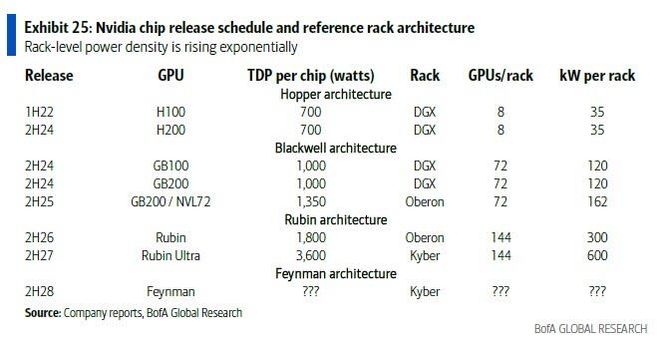

直接的连锁反应,是服务器机架功率密度的急剧攀升。在AI训练集群中,网络延迟是性能的致命瓶颈。为最大限度降低GPU之间的数据传输延迟,工程师的解决方案是将尽可能多的GPU紧密集成在同一个服务器机架内,通过高速内部互联(如NVLink)进行通信。这一架构优化的必然结果,就是机架功率密度的爆炸式增长。在2021年,数据中心的平均机架密度尚不足10千瓦(kW);如今,一个标准的英伟达Hopper(H200)机架功耗已达35kW,最新的Blackwell(B200)机架更是高达120kW。根据英伟达公布的路线图,其计划于2027年下半年推出的Rubin Ultra平台,单机架功耗将达到前所未有的600kW。AMD的MI350和未来的MI400,以及英特尔的Gaudi系列,也遵循着同样的轨迹。

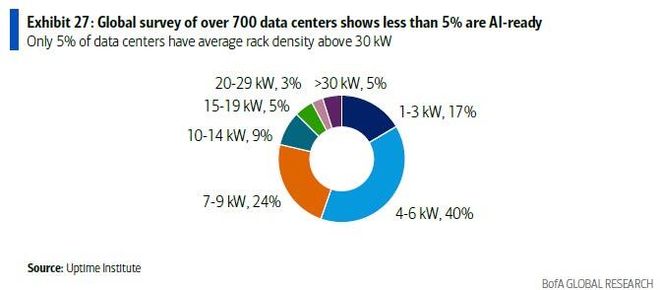

与此同时,全球存量数据中心基础设施建设却严重滞后。根据权威机构Uptime Institute在2024年的调查,全球仅有5%的现有数据中心,其平均机架密度能够超过30kW。这意味着,95%的数据中心甚至无法支持英伟达上一代的Hopper芯片,更不用说功耗更高的Blackwell。因此,AI算力的部署,必须依赖于一场对现有数据中心的大规模升级改造和海量的新建。

值得强调的是,这并非GPU的专属路径。包括谷歌(TPU)、微软(Maia 100)和亚马逊(Trainium)在内的云巨头,其自研的ASIC芯片尽管在特定任务上能效更高,但为了追求极致性能,同样纷纷宣布其最新一代产品必须采用液冷散热。这从另一个角度也印证了,高密度计算带来的散热挑战,可能是整个AI硬件行业不可逆转的共同趋势。

三、重塑基础设施:一场关于“水与电”的变革

由芯片引爆的“密度革命”,正自下而上地对数据中心的基础设施发起冲击,其核心战场集中在两个领域:散热系统(水)与供电系统(电)。

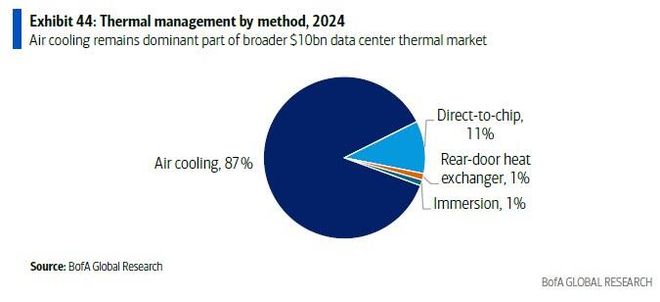

(1)第一战场:散热——从风冷到液冷的迁徙

传统数据中心长期依赖空气进行冷却。然而,即便是设计最优化的风冷系统,其散热能力的物理极限也仅在每机架60-70kW左右。面对动辄上百千瓦的AI机架,风冷已无能为力。液冷,这一曾在大型机时代短暂出现的技术,正以无可争议的姿态回归主流。

在众多液冷技术路线中,行业目前的主流选择是“芯片级直接液冷”(Direct-to-Chip, D2C)。

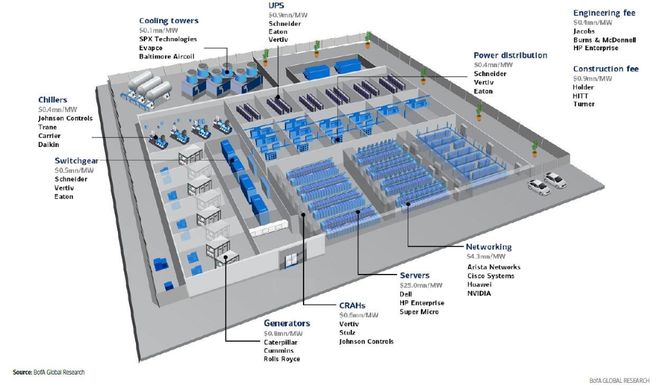

该技术通过一个内含微通道的金属“冷板”(cold plate)直接覆盖在GPU、CPU等主要发热芯片上,内部流动的冷却液(通常是水和乙二醇的混合物)高效地带走热量。其系统核心设备是“冷却液分配单元”(Coolant Distribution Unit, CDU),负责驱动冷却液在服务器内部的“二级回路”和数据中心外部的“一级回路”之间进行热交换和循环。

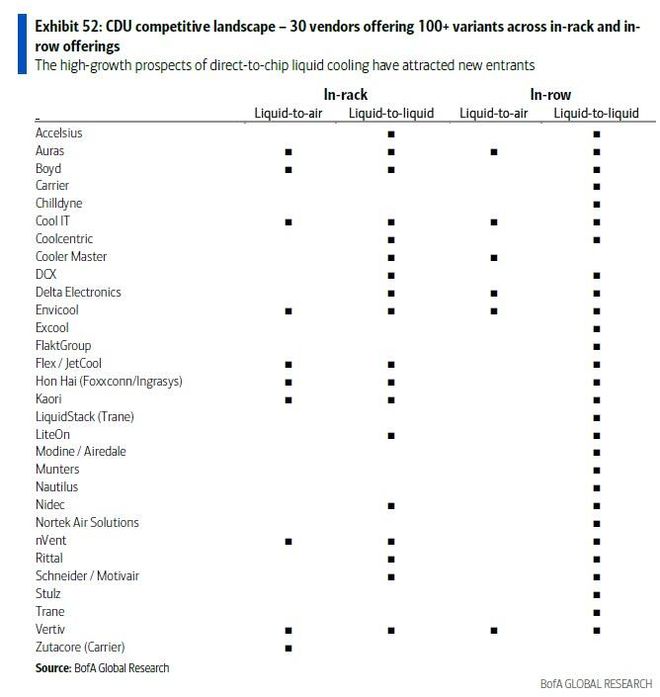

CDU市场虽然在2024年规模仅约12亿美元,但正经历爆发式增长。

目前市场上有超过30家供应商。然而,数据中心运营商对“正常运行时间”(Uptime)的极致追求,决定了他们极度保守,倾向于选择技术成熟、服务可靠的供应商。这使得拥有成熟产品线和全球服务网络的老牌厂商具备天然护城河。维谛(Vertiv,通过2023年收购CoolTera增强了实力)、施耐德电气(Schneider Electric,通过2025年2月收购Motivair布局)、台达电子(Delta Electronics)和nVent等被视为该领域的第一梯队领导者。

(2)第二战场:供电——从交流到高压直流的架构革命

传统数据中心的供电链路漫长且存在能量损耗:来自电网的中高压交流电(AC),经过变压器降压、开关柜分配,进入不间断电源(UPS)进行“AC-DC-AC”的双重转换以备用,再通过配电单元(PDU)或母线槽送至机架,最终在服务器内部由电源供应单元(PSU)完成最后的“AC-DC”转换。

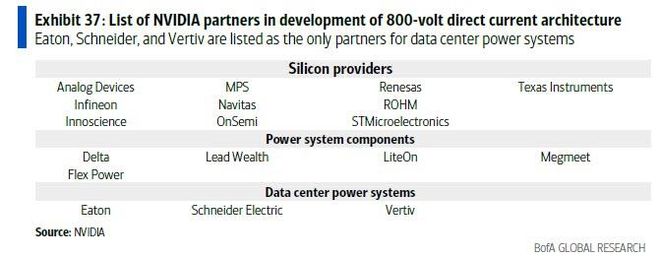

随着AI机架的总功率向100kW以上迈进,传统低压交流供电架构的弊端尽显:巨大的电流导致需要极粗的铜缆,这不仅成本高昂,还占据了宝贵的机架空间并影响散热。为此,一场向“高压直流”(High Voltage DC)的架构革命已然开启。

高压直流的核心优势在于,根据物理原理(功率=电压×电流),在传输相同功率的情况下,将电压提高一个数量级,电流便可降低一个数量级。这意味着可以用直径更细、成本更低的线缆完成输电,从而大幅减少机架内昂贵且笨重的铜材使用量。据施耐德电气测算,400V系统相比传统的208V交流系统可减少52%的铜线重量。

这一变革将深刻重塑供电系统:

UPS简化:在直流架构下,UPS不再需要将电池的直流电逆变为交流电的“逆变器”环节,理论上可降低10-20%的成本(尽管初期可能被高压安全设备成本抵消)。

电源移出服务器:原本位于服务器内部、占用大量空间的PSU,将被移出服务器机架,形成一个独立的“电源边车”(power side car)形态,为计算单元腾出更多空间。

英伟达已明确表示,其800V直流架构将与维谛(Vertiv)、伊顿(Eaton)等行业领导者合作开发,这再次印证了 incumbents(在位者)在行业标准变革中依然占据核心地位。

四、供应链核心环节拆解:谁是淘金热中的“卖铲人”?

AI的崛起,正显著推高数据中心的单位建设成本。一个传统数据中心的总造价(All-in Cost)约为每兆瓦3900万美元,而一个采用下一代AI架构(假设为芯片级液冷和高压直流)的数据中心,其造价将跃升33%,达到每兆瓦5200万美元。增长的部分主要来自更昂贵的AI服务器,但基础设施的升级同样贡献了显著的成本增量。

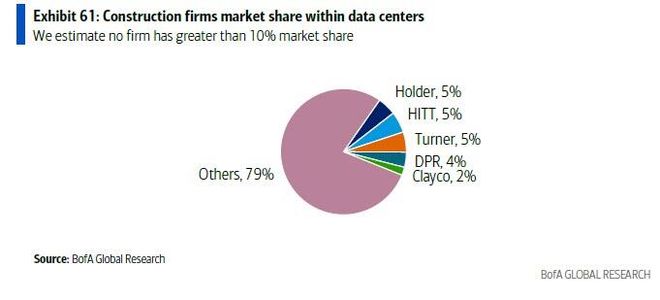

在这条庞大而精密的供应链上,各个环节的“卖铲人”正分享着时代的红利:

结语

我们在屏幕上所见的“AI闭环”和令人惊叹的生成能力,不仅是AI技术的突进,也是一场关乎混凝土、铜缆和冷却液的物理世界基建竞赛。

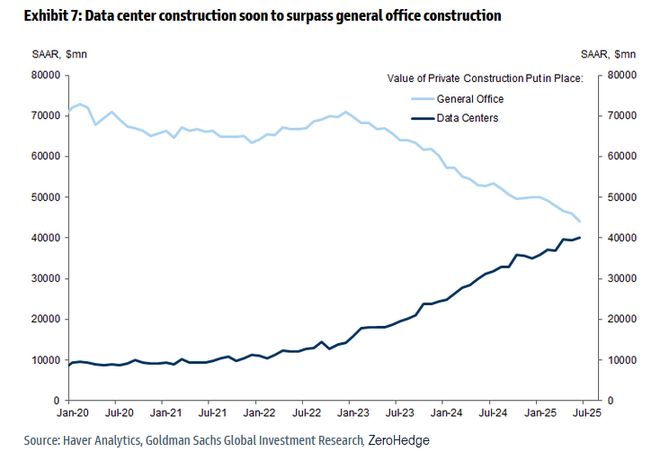

一个极具冲击力的事实是:在未来数月内,全球数据中心的建设支出将历史性地超过所有通用办公楼的建设总和。

在这场由AI点燃的、前所未有的淘金热中,那些掌握着核心散热与供电技术、能够为海量算力“降温”和“喂电”的供应链巨头,无疑将成为这个时代沉默但真正的赢家。

相关文章

负债等于2.6个恒大,中国第一大企业,员工人数超200万……

14亿人也养不活? 作者 :象视汽车 来源:象视汽车(ID:xiangshi-qiche) 公共交通出行领域,铁路远比航空和水路客运量大。 五一小长假14.65 亿人次的出行浪潮中,有超过1亿次的双...

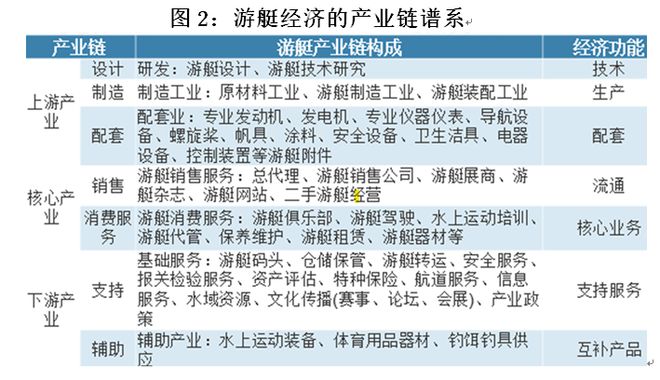

沈建光:中国发展游艇经济的五大带动效应

发展游艇制造业,除了弥补我国造船业的短板之外,还有助于推动船舶制造业加快向高附加值转型。当前我国船舶企业推出了超过11万吨的成品油船、超过8万吨的散货船、6.2万吨的重吊多用途船、双燃料汽车运输船等多...

低空飞行提速,要迈过哪些关卡?

1982年,《银翼杀手》在美国上映。洛杉矶的雨夜天际线中,名为Spinner的警用飞行汽车穿梭于巨型全息广告之间。这个融合了复古轿车与直升机座舱的飞行器,构成了许多人最早对低空飞行的幻想。 40年后,...

中海首只消费REITs上市,1600亿资金认购抢筹,消费REITs缘何成为“香饽饽”?

消费REITs中唯一通过收购盘活资产的代表性项目,正式在二级市场上市。 10月31日,华夏中海商业REIT(180607)在深交所上市,上市首日开盘即涨,涨幅一度达4.90%,截至当天收盘,价格为5....

这个万亿级赛道,按下“加速键”!

文/庞无忌 中共中央办公厅、国务院办公厅印发的《关于持续推进城市更新行动的意见》15日公布。 作为城市更新领域的顶层设计,《意见》明确了推动城市更新的“时间表”“路线图”和“施工图”。分析认为,这意...

特朗普出手后,委内瑞拉石油为何仍然难以快速复产?

汇丰与高盛的最新研报揭示了一个残酷的现实:委内瑞拉石油行业的复苏将是极度缓慢、昂贵且局部的。 据新华社报道,美国白宫已要求美国各大石油公司对委内瑞拉大量投资,修复委内瑞拉原油开采基础设施。 尽管特朗普...

豫ICP备2024079567号-1

豫ICP备2024079567号-1